AI 为什么有时候会胡说?

AI "幻觉"的原因和应对

概述

AI 会"胡说"是因为它不是在"回忆事实",而是在"生成最可能的文本"

关键要点

- 基于概率生成,不是事实回忆

- 训练数据不足会编造内容

- 缺乏事实核查能力

应用场景

- 识别 AI 的错误信息

- 验证 AI 的回答

- 安全使用 AI

常见误区

- 盲目相信 AI 的回答

- 不验证关键信息

- 在专业领域完全依赖 AI

📚 定义&结论

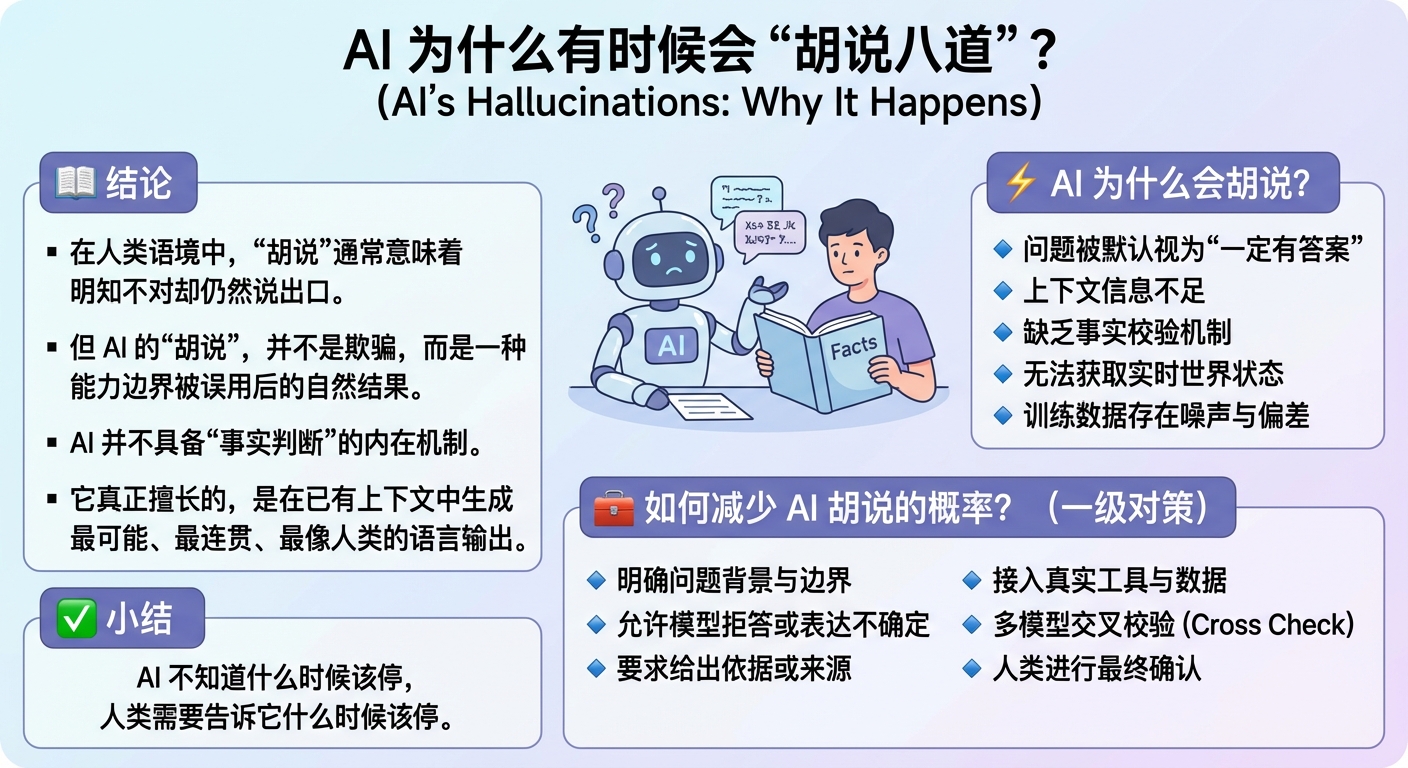

在人类语境中,“胡说”通常意味着明知不对却仍然说出口。但 AI 的“胡说”并不是欺骗,而是一种能力边界被误用后的自然结果。AI 并不具备“事实判断”的内在机制,它真正擅长的,是在已有上下文中生成最可能、最连贯、最像人类的语言输出。

⚡ AI 为什么会胡说?

🔸 原因一:问题本身没有确定答案

当现实中本来就没有标准结论时,AI 仍会尝试给出一个“看起来合理”的回答。

例子:“某家小公司的内部战略是什么?”

🔸 原因二:上下文不充分,AI 被迫猜测

当时间、对象或范围不清楚,AI 会自动补全一个最常见的版本。

例子:“这个政策什么时候开始实施?”(但没说是哪国、哪项政策)

🔸 原因三:AI 不会主动核实事实

除非被要求或有工具支持,否则 AI 不会自己检查答案是否真实。

例子:编造一本听起来很像真的书名和作者。

🔸 原因四:无法获取实时或最新数据

在没有接入实时系统的情况下,AI 只能用旧知识推测现在。

例子:回答今天的股价或最新新闻,却已经过期。

🔸 原因五:训练数据本身可能是错的

AI 学的是人类写过的内容,而人类写的东西本身就可能错误或过时。

例子:重复一个在网上被广泛误传的“常识”。

❓ 那 AI 的胡说,能不能防止?

不能彻底消除,但可以显著降低。关键不在于“让 AI 更聪明”,而在于

给 AI 更清晰的边界、信息和约束条件。

🛠️ 如何减少 AI 胡说的概率?

🔹 把背景说清楚

时间、对象、范围越明确,AI 越不容易自行补全错误信息。

🔹 允许 AI 说“不知道”

明确告诉 AI:不确定时可以拒答,而不是强行回答。

🔹 要求依据或来源

这会明显减少无根据的扩展和编造。

🔹 接入真实工具与数据

当 AI 能查询数据库、实时系统或权威来源时,“猜测式回答”会显著减少。

🔹 关键结论由人类确认

AI 适合做辅助,而不适合作为最终裁判。

🔹 多个模型相互校验(Cross Check)

让不同模型分别回答同一问题,对比结果,更容易发现编造或偏差。

✅ 小结

AI 的“胡说”,并不是因为它不够聪明,而是因为它

并不具备人类意义上的事实责任和现实约束。更准确的说法是:

AI 不知道什么时候该停,人类需要告诉它什么时候该查、该停、该确认。